به گزارش جماران؛ مدتها از حضور ChatGPT میگذرد؛ چتباتی که رنگوبوی جدیدی به دنیای هوش مصنوعی بخشید و نگاه عموم کاربران و همینطور سرمایهگذاران را بیش از قبل به این حوزه جلب کرد. در حقیقت این چتبات ثابت کرد که هوش مصنوعی پتانسیل درآمدزایی بالایی برای بسیاری از غولهای حوزه فناوری دارد؛ اما چرا هوش مصنوعی فناوری گرانقیمت و پرهزینهای محسوب میشود؟

تازهترین گزارش سهماهه گوگل و مایکروسافت از افزایش چشمگیر درآمد ابری این دو شرکت خبر میدهد که دلیل اصلی آن، توجه بیشتر مشتریان به خدمات هوش مصنوعی است. در اثر چنین استقبالی، انتظار میرود که سرمایهگذاران بیشتری پا به حوزه هوش مصنوعی بگذارند و شرکتها نیز خدمات بیشتری را در این زمینه به کاربران ارائه دهند.

بااینحال به نقل از دیجیاتو، افزایش هزینههای تحقیقات و خدمات مبتنی بر AI، برخی سرمایهگذاران را نگران کرده است. برای مثال، ارزش سهام متا به دلیل کاهش برخلاف انتظار درآمدهای ناشی از هوش مصنوعی، افت پیدا کرده و احتمال تکرار سناریو مشابه برای سایر شرکتها نیز وجود دارد.

در ۲۵ آوریل ۲۰۲۴ (۶ اردیبهشت ۱۴۰۳)، مایکروسافت از سرمایهگذاری ۱۴ میلیارد دلاری خود در زمینه AI طی سهماهه اول سال خبر داد که نسبت به مدتزمان مشابه سال گذشته، ۷۹ درصد افزایش داشته و این مبلغ احتمالاً بهصورت تدریجی افزایش خواهد یافت. همچنین شرکت متا نیز سرمایهگذاری خود را نسبت به سال گذشته حدود ۴۲ درصد افزایش داده و با اختصاص بودجه ۳۵ الی ۴۰ میلیارد دلاری، تحقیقات بیشتری را در زمینه هوش مصنوعی دنبال میکند.

انتظار میرفت که شاهد افزایش هزینه توسعه AI باشیم؛ زیرا با گذشت زمان، پیچیدگیها و الگوریتمهای هوش مصنوعی دستخوش تغییرات بیشتری میشوند و همزمان با این موضوع، تقاضا و نیاز عمومی به این فناوری روزبهروز در حال افزایش است. درنتیجه، پاسخگویی به نیاز مشتریان، زیرساختهای بیشتر و البته مجهزتری را میطلبد. با ما همراه شوید تا به بررسی عوامل مؤثر در افزایش هزینههای توسعه هوش مصنوعی بپردازیم.

گسترش مدلهای زبانی هوش مصنوعی

ابزارهای هوش مصنوعی مانند ChatGPT از مدلهای زبانی بزرگی استفاده میکنند که مجموعه وسیعی از دادهها مانند کتابها، مقالات و نظرات را برای ارائه بهینهترین پاسخها به پرسشهای کاربران در اختیار دارند. همچنین بسیاری از شرکتهای پیشرو در این زمینه باور دارند که با پیشرفت روزافزون هوش مصنوعی، نیاز این فناوری به مدلهای زبانی بزرگتر و کاملتر برجستهتر میشود.

گسترش این مدلها به تهیه دادههای کاملتر، تقویت قدرت محاسباتی و آموزش بیشتر سیستمها وابسته است؛ بااینحال انجام چنین فرایندی، به بودجه زیادی نیاز دارد. برای مثال «داریو آمودئی»، مدیرعامل آنتروپیک، طی مصاحبهای اعلام کرد که آموزش مدلهای هوش مصنوعی در شرایط فعلی، چیزی حدود ۱۰۰ میلیون دلار هزینه میبرد. وی همچنین از پیشبینی خود مبنی بر افزایش ۵ الی ۱۰ میلیارد دلاری هزینه آموزش مدلهای آینده (در سالهای ۲۰۲۵ و ۲۰۲۶) سخن گفت.

هزینه سختافزار هوش مصنوعی

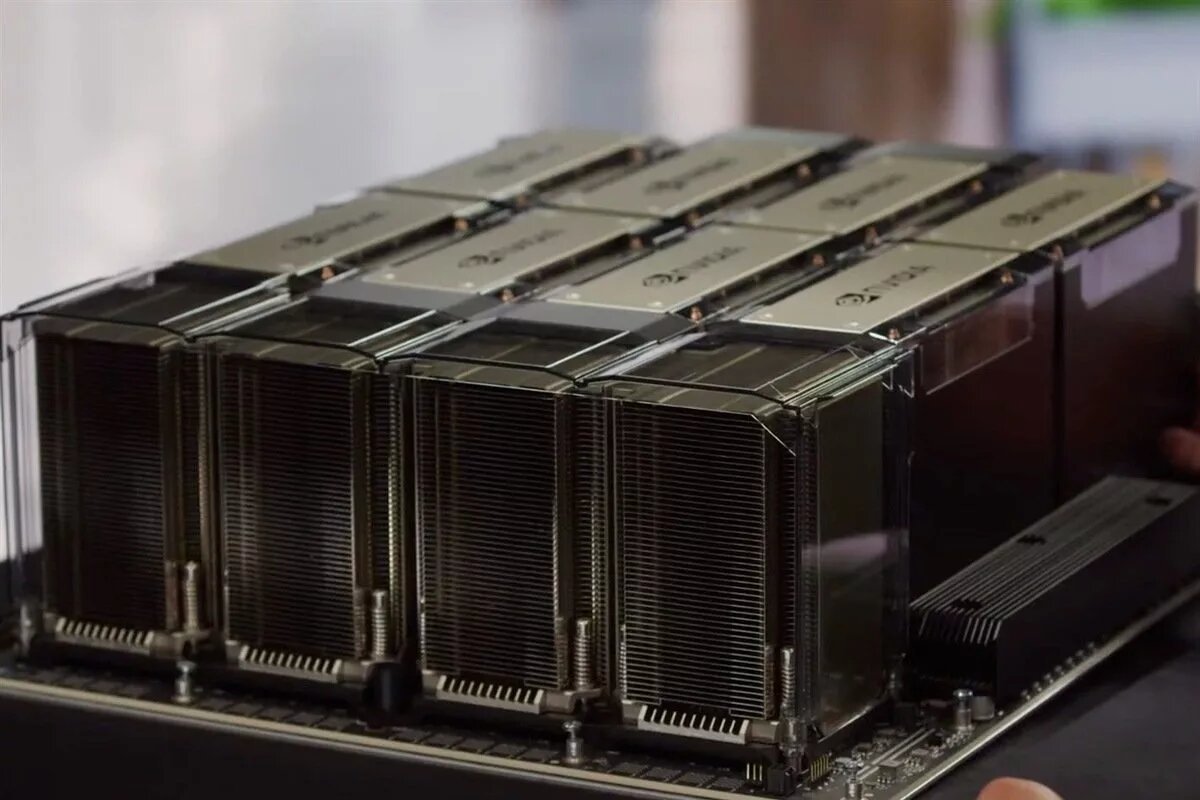

شرکتهای توسعهدهنده AI از پردازشگرهای گرافیکی (GPU)، بهویژه قطعات انویدیا بهمنظور پردازش حجم عظیم دادهها با سرعت بالا استفاده میکنند. بااینحال این قطعات، کمیاب و البته گران هستند و برخی از آنها مانند H100 انویدیا، با قیمت ۳۰ هزار دلار یا حتی بیشتر به فروش میرسند. برخی شرکتها نیز به اجاره قطعات موردنظرشان روی آوردهاند، اما این کار هم هزینه زیادی برای کمپانیها به همراه دارد؛ برای مثال اجاره تعدادی از قطعات H100 انویدیا تقریباً ۱۰۰ دلار در ساعت برای تیم توسعهدهنده آب میخورد.

اخیراً شرکت انویدیا معماری جدیدی از پردازشگرهای خود را با نام بلکول (Blackwell) معرفی کرده که نقش بسزایی در پردازش دادههای هوش مصنوعی ایفا میکند. متخصصان انویدیا تخمین زدهاند که برای آموزش یک مدل AI با ۱۸۰۰ میلیارد پارامتر، مانند GPT-4، به حدود ۲۰۰۰ پردازشگر بلکول نیاز است و این تعداد در صورت استفاده از قطعات Hopper، به ۸۰۰۰ پردازشگر میرسد. درنتیجه هزینه بالای استفاده از این قطعات میتواند سرعت پیشرفت و توسعه هوش مصنوعی و چتباتهای مبتنی بر آن را کاهش دهد.

دیتاسنترها

شرکتها بعد از خرید پردازشگرهای گرافیکی، به مکان مناسبی برای نگهداری و استفاده از آنها نیازمندند. به همین منظور متا، آمازون، مایکروسافت، گوگل و سایر شرکتهای توسعهدهنده، احداث دیتاسنترهای جدید را در نظر دارند؛ مراکزی که سفارشی برای این کمپانیها ساخته میشوند و از قفسههای محکم، سیستمهای خنککننده و انواع تجهیزات الکتریکی مانند ژنراتورهای پشتیبانی بهرهمندند.

گروه تحقیقاتی Dell’Oro تخمین زده است که در سال جاری میلادی، شرکتها حدود ۲۹۴ میلیارد دلار را به ساخت و تجهیز دیتاسنترهای خود اختصاص میدهند. این در حالی است که در سال ۲۰۲۰، حدود ۱۹۳ میلیارد دلار در این زمینه هزینه شده بود که نشان از گسترش خدمات دیجیتالی مانند استریمهای ویدیویی، توسعه دادهها و پلتفرمهای اجتماعی دارد. البته بخشی از این هزینهها برای خرید قطعات گرانقیمت انویدیا و سایر سختافزارهای تخصصی لازم بهمنظور رشد خدمات مبتنی بر AI خرج میشود.

حقوق ناشران

بااینکه عمده هزینهها صرف خرید پردازشگرها و دیتاسنترها میشود، برخی شرکتها میلیونها دلار برای خرید حق نشر مطالب از ناشران هزینه میکنند. بهعنوانمثال، شرکت OpenAI به توافقاتی با چند ناشر اروپایی برای استفاده از محتوا و مطالب آنها در ChatGPT دست یافته و طبق گزارش بلومبرگ، ۱۰ میلیون یورو به شرکت Axel Springer SE بهمنظور حضور محتوای خبری آنها در این چتبات پرداخت میکند. سران OpenAI همچنین با دیگر خبرگزاریها مانند CNN،Time و فاکسنیوز پیرامون این موضوع گفتوگو کردهاند.

دیگر شرکتها نیز بیکار نماندهاند و به دنبال راههایی برای تأمین دادههای زبانی موردنیاز بهمنظور ساخت ابزارهای جذاب AI هستند. به گزارش رویترز، گوگل معاملهای ۶۰ میلیون دلاری برای خرید حق نشر محتوا از ردیت داشته و بر اساس خبر نیویورکتایمز، تیم متا در حال بررسی ارزش خرید حق نشر کتاب Simon & Schuster است. البته که رقابت غولهای حوزه فناوری به خرید حق نشر محدود نشده و آنها در استخدام نیروهای مستعد و توسعهدهندگان ماهر با یکدیگر چالش دارند.

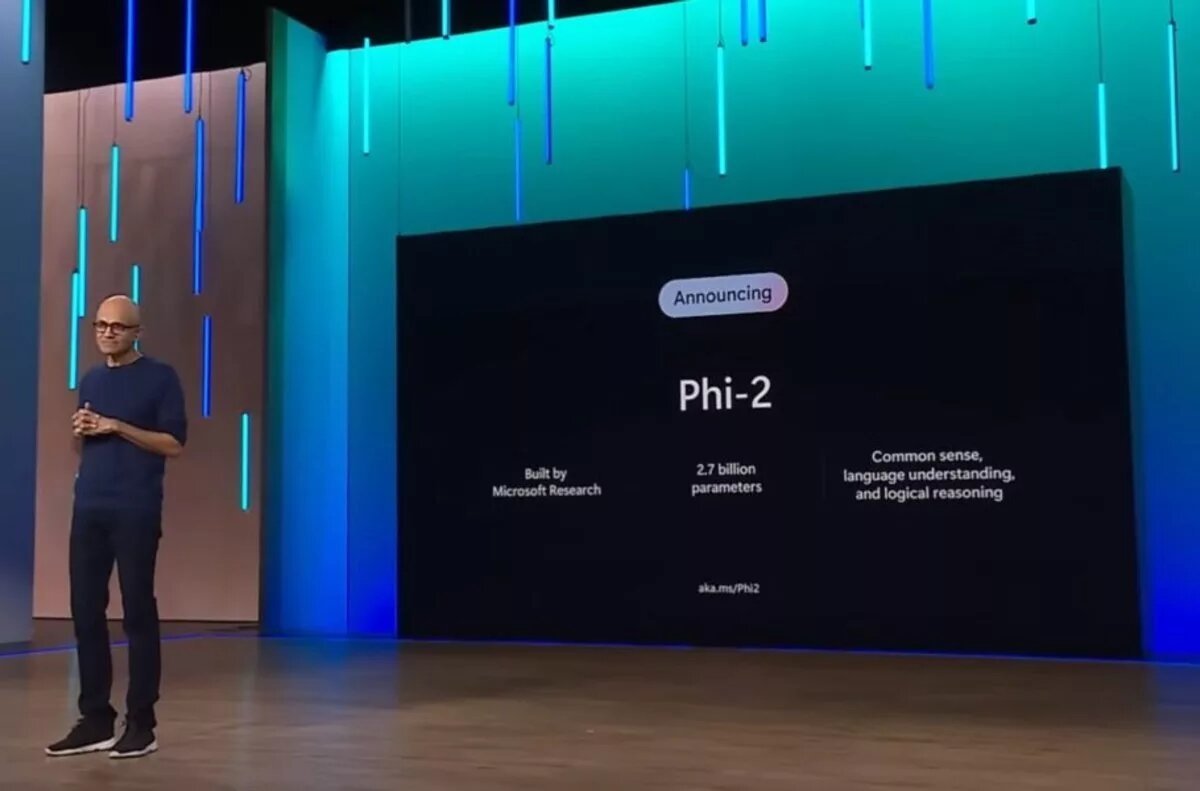

جایگزینهای ارزانتر

علیرغم اینکه مایکروسافت همواره نقش بسزایی در ارائه مدلهای زبانی بزرگ داشته، اما اخیراً اعلام کرده که رویکرد متفاوتی را در پیش میگیرد. درنتیجه این شرکت سه مدل زبانی کوچکتر معرفی کرد که به قدرت محاسباتی کمتری در مقایسه با مدلهای بزرگتر نیاز دارند. علاوه بر مایکروسافت، برخی دیگر از شرکتها مانند Sakana AI بر توسعه مدلهای زبانی کوچکتر تمرکز دارند.

طبق گفته مایکروسافت، مدلهای زبانی بزرگ همچنان اصلیترین ابزار در توسعه، تحلیل و درک دادههای پیچیده آنها هستند؛ بااینحال مدلهای کوچکتر برای برخی فعالیتها میتوانند کاربردی باشند و نیاز به حضور مدلهای بزرگتر را کاهش دهند. البته برخی باور دارند که حضور مدلهای زبانی بزرگ تحت هر شرایطی به نفع کاربران است، حتی اگر هزینه بیشتری به ارمغان بیاورد.

نظر شما