علی شمیرانی - در حالیکه مردم و مقامات کشورهای زیادی در دنیا تحت شنودهای جهانی و عملیاتهای نفوذ سایبری آمریکا هستند، حالا برخی رسانههای این کشور مدتهاست که مدعی قربانی شدن آمریکا به واسطه نفوذهای سایبری خارجی در انتخابات این کشور شدهاند.

در همین راستا سایت کانورسیشن نیز در گزارشی به بررسی نحوه طراحی و اجرای عملیاتهای برونمرزی برای تبدیل شبکههای اجتماعی به ابزار نفوذ پرداخت. اگرچه بهانه اولیه این سایت از گزارش مذکور ادعای مداخلات خارجی در انتخابات آمریکا بود، اما به شکل ناخواسته روش نفوذ آمریکا در بستر شبکههای اجتماعی به دیگر کشورها، تشریح شده است. نکته حایز اهمیت دیگر آنکه پیش از این و به ویژه در زمان کرونا نفوذ نهادهای امنیتی آمریکا و دستورات مستمر آنها جهت دستکاری محتوا به مدیران شبکههای اجتماعی که عمدتا در خاک این کشور فعالیت دارند، بارها رسانهای شده است.

به عبارت دیگر شبکههای اجتماعی عموما ابزار و مجریان بیقید و شرط در دست نهادهای اطلاعاتی آمریکا جهت حذف، گستردهسازی، برجستهسازی و جهتدهی به افکار عمومی و متناسب با خواست این نهادها هستند که این امر ضمن تسهیل استفاده از این شبکهها برای اهداف آمریکا، کار شناسایی و توقف عملیاتهای نفوذ را برای دیگر کشورها ناممکن میکند.

در گزارش این سایت آمده است: عملیات نفوذ خارجی یا عملیات اطلاعاتی، در آستانه انتخابات ریاستجمهوری ۲۰۲۴ ایالات متحده آمریکا، به طور گسترده انجام شد. این کمپینهای نفوذ، تلاشهای وسیع برای تغییر افکار عمومی، پیشبرد روایتهای نادرست یا تغییر رفتارها در بین جمعیت هدف را شامل میشدند و روسیه، چین، ایران، اسرائیل و دیگر کشورها، این کمپینها را با بهرهبرداری از رباتهای اجتماعی، ابنفلوئنسرها، شرکتهای رسانهای و هوش مصنوعی مولد راهاندازی کردند.

فیلیپو منچر، استاد علوم اطلاعات و کامپیوتر دانشگاه ایندیانای آمریکا در رصدخانه اجتماعی این دانشگاه و همکارانش با بررسی کمپینهای نفوذ، راهحلهای فنی و الگوریتمهایی را برای شناسایی و مقابله با نفوذ رسانههای اجتماعی طراحی میکنند. در ادامه، نتایج این بررسی به نقل از سایت Theconversation، از دیدگاه این پژوهشگر و استاد دانشگاه، ارائه شده است.

روشهای پیشرفتهای که در رصدخانه اجتماعی، توسعه پیدا کرده، از چندین شاخص برای شناسایی فعالیتهای آنلاین استفاده میکند که محققان، آن را «رفتارهای هماهنگ غیرواقعی» مینامند. ما آن دسته از خوشههای اکانتهای رسانههای اجتماعی را شناسایی میکنیم که به طور هماهنگ پست میگذارند، گروههای کاربران را تقویت میکنند، مجموعههای یکسانی از پیوندها، تصاویر یا هشتگها را به اشتراک میگذارند و یا توالیهای مشکوک مشابهی از اقدامات مختلف انجام میدهند.

ما نمونههای زیادی از رفتار غیرواقعی هماهنگ را کشف کردهایم. به عنوان مثال، حسابهایی را پیدا کردیم که در یک روز، شبکه را با دهها یا صدها هزار پست پر میکنند. یک کمپین مشابه میتواند یک پیام را با یک حساب منتشر کند و سپس حسابهای دیگری که توسط سازماندهندگان آن کنترل میشوند، آن را صدها بار در مدت زمان کوتاهی «لایک» و دیسلایک» کنند.

هنگامی که کمپین به هدف میرسد، میتوان همه این پیامها را برای اجتناب از شناسایی حذف کرد. با استفاده از این ترفندها، دولتها و نمایندگان خارجی میتوانند الگوریتمهای رسانههای اجتماعی را که تعیین میکنند چهچیزی در حال ترند شدن و چهچیزی جذاب است، دستکاری کنند تا تصمیم بگیرند کاربران چهچیزی را در فیدهای خود مشاهده کنند. البته روسیه، چین و ایران، تنها دولتهای خارجیای نیستند که رسانههای اجتماعی را برای نفوذ بر سیاستهای آمریکا دستکاری میکنند.

• هوش مصنوعی مولد

یکی از تکنیکهای رایج و فزاینده، ایجاد و مدیریت ارتش اکانتهای جعلی با استفاده از هوش مصنوعی مولد است. در ادامه این گزارش ادعا شده: ما 1420 حساب جعلی ایکس (توییتر سابق) را تحلیل کردیم که از تصاویر چهرههای تولیدشده با هوش مصنوعی به عنوان عکس پروفایل استفاده کرده بودند. این حسابها برای توزیع کلاهبرداری، هرزنامه و تقویت پیامهای هماهنگ و دیگر فعالیتها استفاده میشدند.

ما تخمین میزنیم که حداقل 10 هزار حساب مشابه، به طور روزانه در این پلتفرم فعال بودند. این موضوع، قبل از آن بود که ایلان ماسک، مدیرعامل ایکس، به طرز چشمگیری تیمهای اعتماد و ایمنی پلتفرم را کاهش دهد. ما همچنین یک شبکه از 1140 ربات شناسایی کردیم که از چتجیپیتی (ChatGPT)، برای تولید محتوای انساننما به منظور تبلیغ وبسایتهای اخبار جعلی و کلاهبرداریهای ارز دیجیتال استفاده میکردند.

این رباتها، علاوه بر پست کردن محتوای تولیدشده توسط ماشین، نظرات مضر و تصاویر سرقتشده، از طریق پاسخها و ریتوییتها نیز با یکدیگر و با انسانها تعامل داشتند. مدلهای تشخیص محتوای پیشرفته کنونی، نمیتوانند بین رباتهای اجتماعی فعال با هوش مصنوعی و حسابهای انسانی، تمایز قائل شوند.

• رفتار نامناسب

پیامدهای چنین عملیاتی به دلیل چالشهای ناشی از جمعآوری دادهها و انجام آزمایشهای اخلاقی که بر جوامع آنلاین تاثیر میگذارد، دشوار است. برای مثال، مشخص نیست که آیا کمپینهای نفوذ آنلاین توانستهاند بر نتایج انتخابات تاثیر بگذارند یا خیر.

با این حال، درک آسیبپذیری جامعه در برابر تاکتیکهای مختلف دستکاری اطلاعات، بسیار حائز اهمیت است. در مقاله اخیر، ما مدلی به نام سیمسام (SimSoM) را معرفی کردیم که نحوه گسترش اطلاعات در شبکه اجتماعی را شبیهسازی میکند. این مدل دارای اجزای کلیدی پلتفرمهایی مانند اینستاگرام، ایکس، تردز (Threads)، بلوسکای (Bluesky) و مستودون (Mastodon) است: یک شبکه مبتنی بر مشاهده و تجربه، یک الگوریتم فید، مکانیسمهای اشتراکگذاری، اشتراکگذاری دوباره و معیارهایی برای کیفیت محتوا، جذابیت و تعامل.

مدل یادشده به محققان امکان میدهد سناریوهایی را بررسی کنند که در آن شبکه، توسط بازیگران بد که حسابهای غیرواقعی را کنترل میکنند، دستکاری میشود. هدف این بازیگران بد، انتشار اطلاعات با کیفیت پایین، مانند اطلاعات نادرست، نظریات توطئه، بدافزار یا دیگر پیامهای مضر است. ما میتوانیم تاثیر تاکتیکهای دستکاری خصمانه را با سنجش کیفیت اطلاعاتی که کاربران هدف در شبکه با آن مواجهند، برآورد کنیم. ما سناریوهایی را شبیهسازی کردیم تا تاثیر سه تاکتیک دستکاری را ارزیابی نماییم:

اول- نفوذ: بهگونهای که حسابهای جعلی، تعاملات قابلباور با کاربران انسانی در یک جامعه هدف ایجاد کنند و آن کاربران را به دنبال کردن ترغیب نمایند.

دوم - فریب: بهطوری که حسابهای جعلی، محتوای جذاب منتشر کنند تا احتمالا توسط کاربران هدف، دوباره اشتراکگذاری شود. رباتها میتوانند این کار را با استفاده از واکنشهای احساسی و همراستایی سیاسی انجام دهند.

سوم - سیل (بمباران) اطلاعات: به معنای انتشار حجم بالایی از محتوا.

این مدل نشان میدهد نفوذ، موثرترین تاکتیک است و کیفیت متوسط محتوا در سیستم را بیش از ۵۰ درصد کاهش میدهد. این آسیب میتواند با سیل اطلاعات شبکه و محتوای کیفیت پایین اما جذاب، بیشتر تشدید شود و کیفیت را به ۷۰ درصد کاهش دهد.

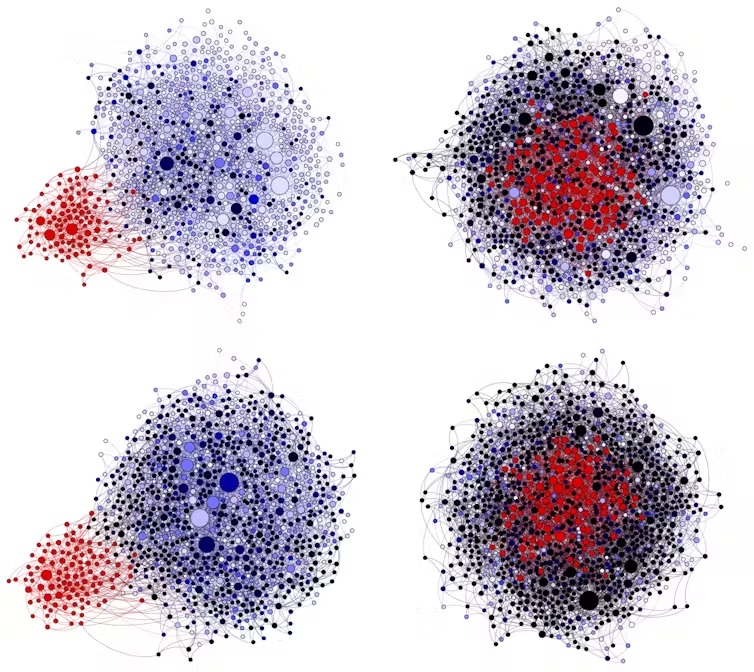

توضیح شکل: در این آزمایش شبیهسازیشده درباره رسانههای اجتماعی، نقاط قرمز، نمایانگر حسابهای جعلی رسانههای اجتماعی و نقاط آبی روشن، بیانگر کاربران انسانی هستند که در معرض محتوای با کیفیت بالاتر قرار دارند. نقاط سیاه نیز نشانگر کاربران انسانی هستند که در معرض محتوای با کیفیت پایینتر قرار دارند. زمانی که حسابهای جعلی به شبکههای کاربران نفوذ و محتوای فریبنده وسیعی تولید میکنند، بیشتر در معرض محتوایی با کیفیت پایین قرار میگیرند. ستون سمت راست، نشاندهنده نفوذ بیشتر و ردیف پایین، بیانگر حجم بیشتری از محتوای فریبنده است

• مقابله با دستکاریهای هماهنگ

ما این تاکتیکها را در عمل مشاهده کردهایم. نگرانی ویژه این است که مدلهای هوش مصنوعی مولد میتوانند ایجاد اکانتهای قابلباور و مدیریت آن را برای بازیگران بد، به مراتب آسانتر و ارزانتر کنند. علاوه بر این، آنها میتوانند از هوش مصنوعی مولد برای تعامل مداوم با انسانها و تولید و انتشار محتوای مضر اما جذاب به صورت گسترده استفاده نمایند. تمامی این قابلیتها برای نفوذ به شبکههای کاربران رسانههای اجتماعی و بمباران اطلاعاتی فیدهای آنها با پستهای فریبنده بهکار گرفته میشود.

این بینشها نشان میدهد پلتفرمهای رسانههای اجتماعی باید در مدیریت محتوا بیشتر، و نه کمتر، فعال باشند تا کمپینهای دستکاری را شناسایی و متوقف کنند و در نتیجه، تابآوری کاربران را در برابر این کمپینها افزایش دهند. این پلتفرمها میتوانند با دشوارتر کردن شرایط ایجاد اکانتهای جعلی و پستگذاری خودکار برای بازیگران بد، به این هدف دست یابند.

آنها همچنین میتوانند از اکانتهایی که با سرعت بسیار بالا پست میگذارند، بخواهند که ثابت کنند انسان هستند. پس پلتفرمها میتوانند این موانع را به تلاشهای آموزشی بیفزایند مانند تشویق کاربران به اشتراکگذاری اطلاعات صحیح. آنها همچنین قادرند کاربران را در زمینه آسیبپذیری در برابر محتوای فریبنده تولیدشده توسط هوش مصنوعی آموزش دهند.

مدلها و دادههای هوش مصنوعی متن باز، این امکان را برای بازیگران بد فراهم میآورند که ابزارهای هوش مصنوعی مولد خود را بسازند. بنابراین مقررات باید بر توزیع محتوای هوش مصنوعی از طریق پلتفرمهای رسانههای اجتماعی تمرکز کنند نه بر تولید محتوای هوش مصنوعی. به عنوان مثال، قبل از اینکه تعداد زیادی از افراد در معرض یک محتوا قرار بگیرند، یک پلتفرم میتواند از سازنده بخواهد تا دقت یا منشأ آن محتوا را ثابت کند.

این نوع مدیریت محتوا، آزادی بیان را نیز در ساحتهای عمومی مدرن محافظت میکند، نه اینکه سانسور کند. حق آزادی بیان، حق در معرض قرار گرفتن نیست و از آنجا که توجه افراد، محدود است، عملیات نفوذ میتواند نوعی سانسور باشد که صدا و نظرات واقعی را کمتر، قابل مشاهده کند. (منبع:عصرارتباط)